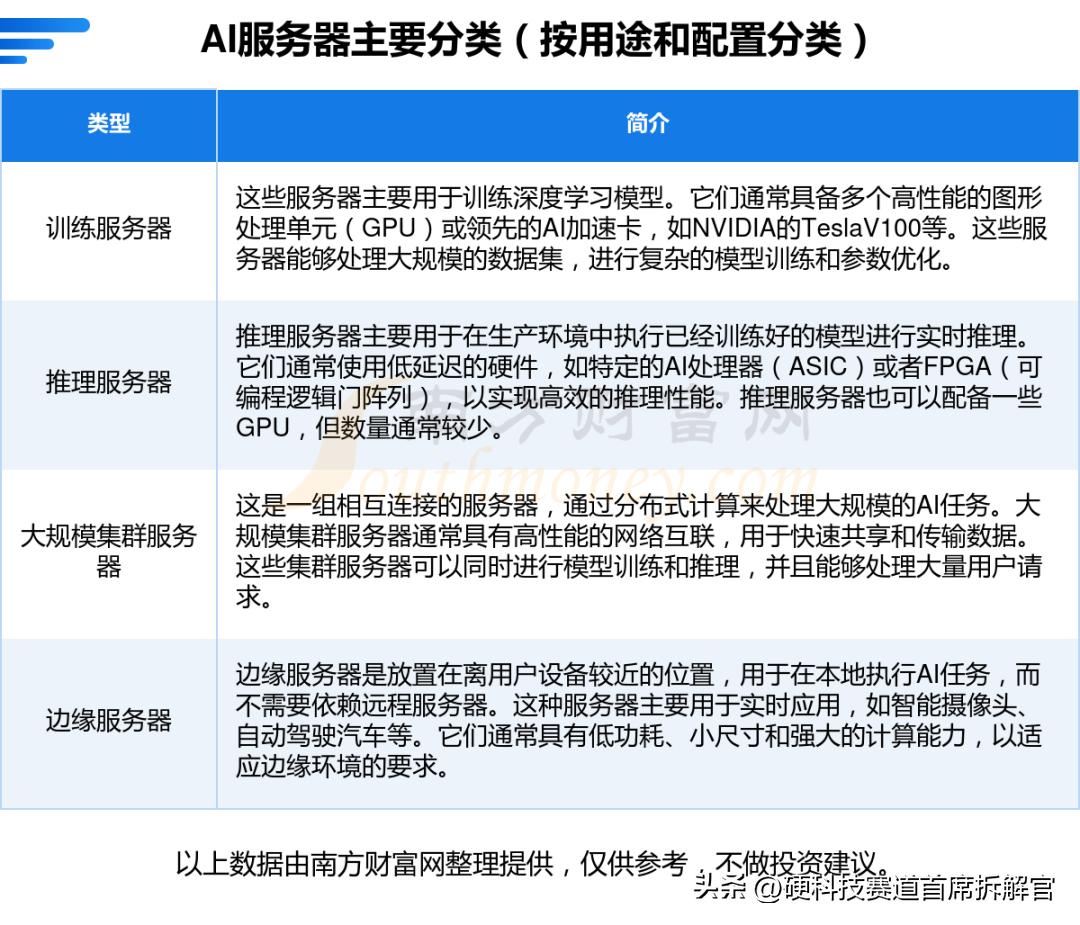

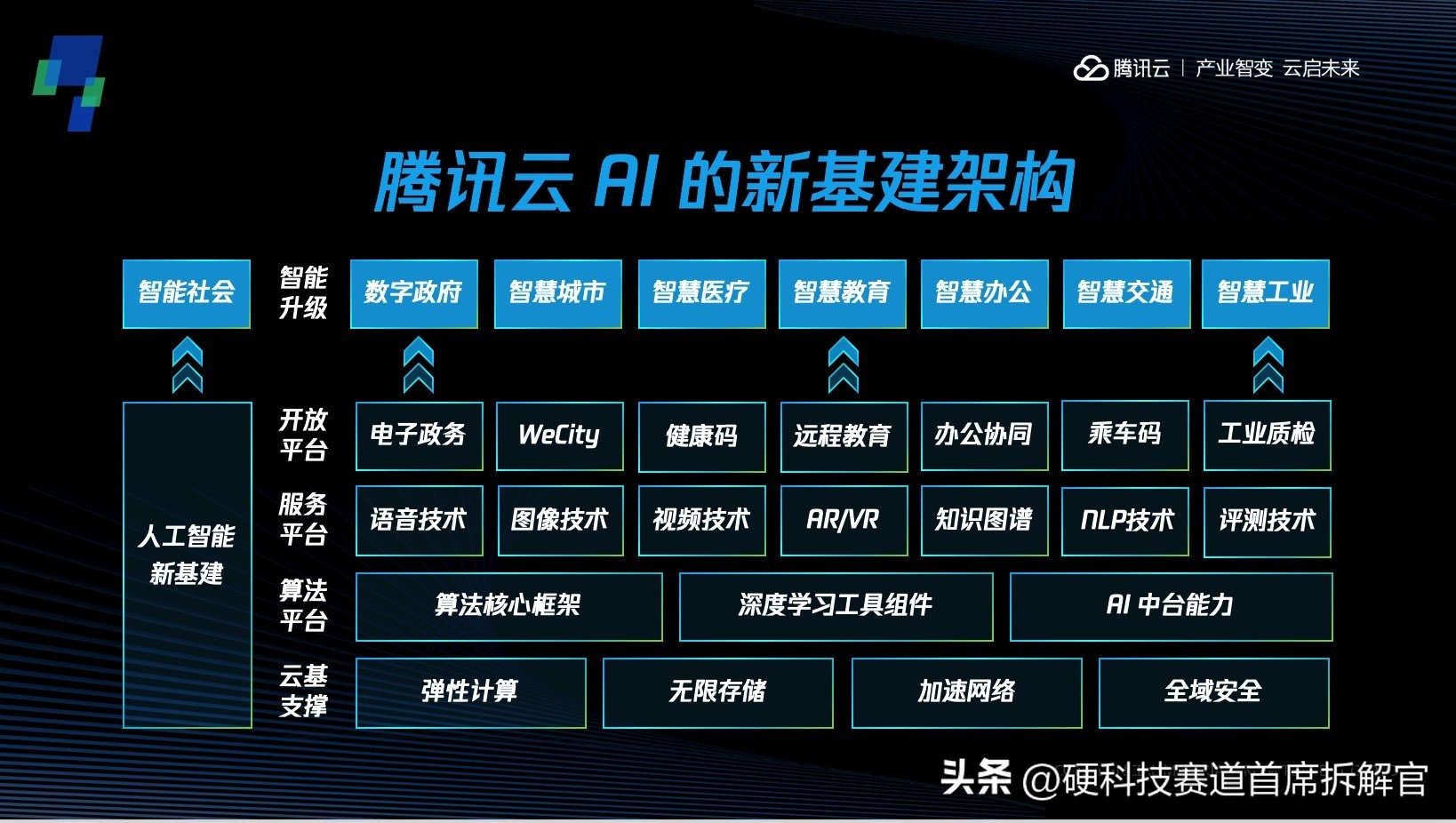

在AI大模型时代,服务器已经不再是传统意义上的“计算盒子”,而是支撑整个智能产业的“算力发动机”。无论是ChatGPT这样的生成式AI,还是自动驾驶、智能工厂、金融风控,背后都依赖于庞大的AI服务器集群。本文将系统梳理AI服务器的部署方案,从硬件选择、网络架构、虚拟化与容器,到算力调度与运维安全,帮助读者理解一个完整的AI服务器部署全景。

一、为什么AI服务器如此重要?1. AI算力需求爆发2. 与传统服务器的区别

二、AI服务器的核心硬件选择1. 处理器(CPU & GPU)2. 内存与高速缓存3. 网络与互联4. 存储系统三、AI服务器的基础架构设计1. 单机到集群2. 集群架构3. 数据中心环境四、虚拟化与容器化方案1. 虚拟化2. 容器化3. 混合方案五、算力调度与集群管理1. 作业调度2. 资源管理3. 监控与可观测性六、AI服务器部署的安全与合规1. 网络安全2. 数据安全3. 合规与绿色计算七、典型部署场景案例1. 云服务商(阿里云、AWS、GCP)2. 科研机构3. 企业自建数据中心

八、部署流程与实施步骤步骤1:需求评估步骤2:硬件选型步骤3:机房环境准备步骤4:操作系统与驱动安装步骤5:容器与调度系统部署步骤6:AI框架适配步骤7:运维与监控

九、未来趋势与展望国产化替代:国产GPU、AI芯片、网络设备快速发展。液冷技术普及:解决功耗与散热难题。AI+大数据一体化平台:训练、推理、数据治理一站式。边缘AI服务器:5G+边缘计算结合,服务自动驾驶、工业IoT。结语

AI服务器的部署不仅是硬件堆叠,更是系统工程。它涉及底层芯片、操作系统、虚拟化、集群管理、数据安全、绿色节能等全链条。对于企业来说,部署方案的科学性将直接决定AI应用的落地效率与成本效益。在未来三到五年,谁能在算力布局上抢占先机,谁就能在AI产业的浪潮中站稳脚跟。

互动收尾:你觉得未来AI服务器的瓶颈是在GPU供给,还是在数据中心能耗?欢迎留言讨论

相关文章